Ratgeber

4K-Fernseher sind in immer mehr Wohnzimmern zu finden. Auch PC-Nutzer und -Nutzerinnen greifen verstärkt zu Bildschirmen mit UHD-Auflösung, denn auf einem 4K-Monitor kann man PC-Spiele in hervorragender Bildqualität genießen. Die hohe Auflösung verlangt allerdings einiges an Hardware-Power.

In unserem Ratgeber erfahren Sie, was 4K-Monitore auszeichnet und worauf Sie bei der Auswahl achten sollten.

Filme, Serien und Videospiele in 4K genießen – das ist heutzutage kaum noch etwas Besonderes, zumindest wenn sie über den TV-Bildschirm flimmern. 4K-Fernseher sind längst nicht so teuer, wie sie es mal waren. Viele Inhalte der Video-on-Demand-Anbieter lassen sich in UHD streamen und auch bezüglich Spielkonsolen bildet 4K keine Ausnahme mehr. Die PlayStation 5 und Xbox Series X haben genug Leistung, um virtuelle Welten in nativer 4K-Auflösung erleben zu können.

Im PC-Bereich hingegen ist Full-HD noch Standard. Die meisten Nutzer und Nutzerinnen verwenden 1080p-Bildschirme. Monitore mit höherer Auflösung sind aber immer mehr im Kommen.

Wer seinen Rechner primär zum Arbeiten oder Surfen im Internet nutzt, mag es gar nicht als notwendig erachten, sich einen 4K-Monitor zuzulegen – erst recht nicht, wenn Streaming-Angebote lieber gemütlich von der Wohnzimmercouch aus auf dem Fernseher konsumiert werden.

UHD-Auflösung bisher vor allem im Gaming-Bereich

Es stimmt daher schon, dass Bildschirme mit einer UHD-Auflösung von 3840 x 2160 Pixeln in erster Linie für Gamer und Gamerinnen gedacht sind. Nichtsdestotrotz sei gesagt, dass das gegenüber einem Full-HD-Modell deutlich schärfere Bild eines 4K-Monitors auch das Arbeitserlebnis aufwertet.

Wenn man einmal in den Genuss eines UHD-Bilds gekommen ist, möchte man nicht mehr zurück. 1080p wirken dann auf einmal viel unschärfer.

4K fordert große Rechenleistung

Letztendlich ist es aber der Gaming-Industrie – genauer gesagt, den Herstellern von Grafikkarten für Spielefans – zu verdanken, dass 4K-Monitore immer mehr an Beliebtheit gewinnen. Erst seit der GeForce-20-Serie von NVIDIA und der Radeon-RX-5000-Baureihe von Konkurrent AMD ist 4K-Gaming am PC mit vernünftigen Bildraten möglich.

Fest steht: Das Spielen in UHD verlangt viel Rechenleistung. Die Auflösung ist viermal so hoch wie 1080p und man bedenke, dass moderne Spiele mit hochauflösenden Texturen, enorm detailreichen Welten und aufwendigen Effekten wie Raytracing bereits in Full-HD selbst starken PCs einiges abverlangen.

Nicht selten bedeutet Spielen in 4K, bei den Grafikdetails Kompromisse eingehen zu müssen, sofern man wenigstens im Durchschnitt 60 FPS haben möchte. Das wird sich in den kommenden Jahren, wenn die Hardware noch besser wird, jedoch ändern – bis 4K schließlich der neue Standard ist.

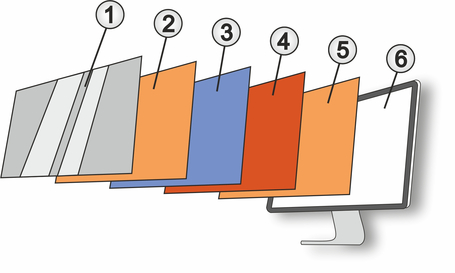

Bei modernen PC-Bildschirmen handelt es sich stets um LCD-Monitore (Liquid Crystal Display). Ihren Namen verdanken sie dem Panel aus Flüssigkristallen, das zwischen der Rückwand und dem Rahmen sitzt. In Kombination mit einer Hintergrundbeleuchtung erzeugt es auf Basis der Informationen, die der PC an den Monitor sendet, die entsprechenden Bilder.

Bei älteren Modellen besteht die Hintergrundbeleuchtung aus Kaltkathodenröhren, mittlerweile kommen LEDs, also Leuchtdioden, zum Einsatz, deren Betrieb weniger Energie kostet und die in der Herstellung wesentlich umweltfreundlicher sind. Deshalb ist heutzutage auch oft von LED-Monitoren die Rede, was aber nichts daran ändert, dass es sich immer noch um LCD-Bildschirme handelt.

Nun ist jedoch LCD-Panel nicht gleich LCD-Panel. Man unterscheidet zwischen drei Arten: TN-Panels, IPS-Panels und VA-Panels.

TN-Panels – Twisted Nemantic

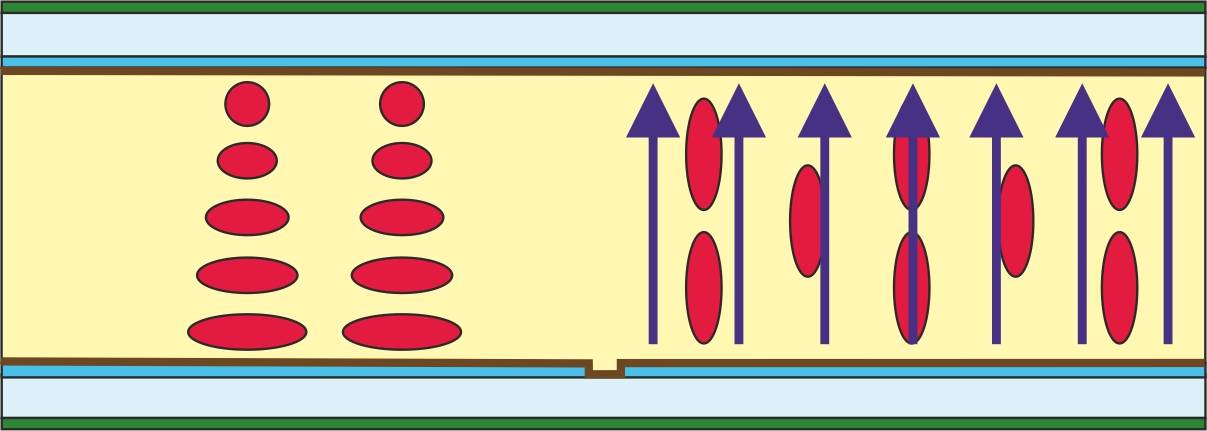

Bei den TN-Panels (Twisted Nemantic) besteht jedes einzelne Pixel aus Flüssigkristallen, die sich in der Tiefe ausrichten. Sie haben zwei große Vorteile: Sie sind die günstigsten Panels auf dem Markt und haben zugleich die schnellsten Reaktionszeiten, wechseln ein Pixel also am schnellsten von Schwarz zu Weiß. Dafür fällt die Farbdarstellung eher unterdurchschnittlich aus und es kann zu starken Farbveränderungen kommen, wenn sich der Blickwinkel auf den Bildschirm ändert.

>> TN-Monitore sind gute Allzweckbildschirme und perfekt für alle, die nicht so viel Geld investieren möchten.

IPS-Panels – In Plane Switching

Demgegenüber stehen die IPS-Panels (In Plane Switching). Hier sind die Kristalle parallel übereinander angeordnet und bewegen sich immer auf einer Ebene, was für höhere Blickwinkelstabilität sorgt. Die IPS-Technologie bietet die beste Farbdarstellung und kann im Gegensatz zu einem TN-Display auch Kontraste besser abbilden – dafür ist aber auch der Stromverbrauch recht hoch und entsprechende Bildschirme sind teurer als die Alternativen.

>> IPS-Bildschirme eignen sich am besten für professionelles Arbeiten, was eine korrekte Farbdarstellung erfordert, oder für Gamer, die vor allem Wert auf eine gute Bildqualität legen.

VA-Panels – Vertical Alignment

Die VA-Modellen (Vertical Alignment) verfügen über vertikal angeordnete Flüssigkristalle, die sich in die Horizontale drehen. Im Vergleich mit anderen Panel-Typen haben sie hinsichtlich des Schwarzwerts und Kontrasts klar die Nase vorn und zumindest schnellere Reaktionszeiten als IPS-Panels. Dafür ist die Farbtreue nicht ganz so gut.

>> Super für Film- und Serienliebhaber, Grafikdesignerinnen und alle, die sich einen grafisch detailreichen Bildschirm wünschen.

Bei vielen der heutigen Monitore und eben auch bei UHD-Bildschirmen wird nicht nur mit der Auflösung, Bildschirmgröße und Reaktionszeit geworben, sondern auch mit den Begriffen HDR, AMD FreeSync und NVIDIA G-Sync. Doch wofür braucht man das? Im Fall von HDR ist das relativ einfach zu erklären: Die Abkürzung steht für High Dynamic Range, das für ein größeres Farbspektrum und deutlich besser dargestellte Helligkeitsunterschiede sorgt. Ein Monitor mit HDR-Modus ist somit vor allem für diejenigen geeignet, die entweder viel am PC spielen oder Videos beziehungsweise Bilder bearbeiten.

Allerdings muss auch die restliche Hardware die Technologie unterstützen. NVIDIA-Grafikkarten sind seit der 900er-Serie in der Lage, HDR-Bilder zu erzeugen, bei AMD hat der Support mit der Radeon-RX-400-Reihe begonnen. Des Weiteren hängt auch vom verwendeten Kabel ab, ob HDR nutzbar ist oder nicht: Es muss mindestens ein HDMI-2.0a- oder DisplayPort-1.2-Kabel Grafikkarte und Bildschirm miteinander verbinden, sonst bleibt einem der HDR-Genuss vorenthalten.

Adaptive Synchronisation ist anders als HDR ein Feature, das sich voll und ganz an Gamer und Gamerinnen richtet.

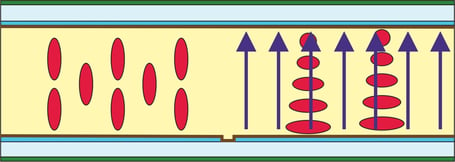

Es gibt zwei Varianten davon: FreeSync von AMD und G-Sync von NVIDIA. Grundsätzlich machen beide das Gleiche: Sie passen die Bildwiederholrate des Monitors an die von der Grafikkarte ausgegebenen Bilder an. Das hat so einige Vorteile.

Ohne Bildsynchronisation droht "Bildzerreißen"

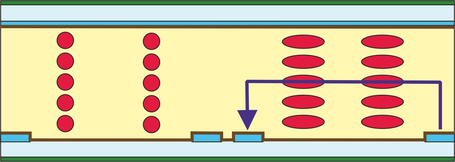

Ohne eine Form der Bildsynchronisation kann sogenanntes Screen Tearing (Bildzerreißen) auftreten: Der Monitor fragt die Grafikkarte nach einem Bild, das aber noch nicht komplett berechnet ist, und zeigt deshalb nur den fertigen Teil an. Der Rest des Bildschirms wird noch vom vorherigen Frame ausgefüllt. Dadurch sieht es vor allem bei schnellen Bewegungen so aus, als würde das Bild zerreißen.

VSync – mehr Pflaster als Heilmittel

Eine softwareseitige Lösung für dieses Problem ist VSync (Vertikale Synchronisation). Anders als FreeSync und G-Sync passt sich das Tempo, in dem die Grafikkarte Bilder ausgibt, an die Bildwiederholfrequenz des Monitors an. Die Bildrate wird also limitiert. Ist die Grafikkarte zudem nicht leistungsstark genug, um so viele FPS zu liefern, wie sie der Bildschirm darstellen kann, muss dieser auf die Bilder warten, was zu Rucklern führt – selbst bei Bildraten, die eigentlich ein flüssiges Spielerlebnis bieten sollten.

G-Sync – Teuer aber gut

Mit FreeSync und G-Sync hat man das Problem nicht, da sich der Monitor der Grafikkarte anpasst und beide synchron laufen. Das sorgt für ein flüssiges Bild.

Was man jedoch beachten sollte: Für G-Sync ist eigentlich ein Extramodul nötig, das nicht in vielen Bildschirme verbaut ist. Und die Modelle, die mit dieser Technologie ausgestattet sind, sind im Vergleich zudem ziemlich teuer. Außerdem deaktiviert das NVIDIA-Modul die integrierten optionalen Bildverbesserungen des Monitors und berechnet die Bilder selbst. Das macht Gaming-Features unbrauchbar, die beispielsweise die Helligkeit in dunklen Spielbereichen erhöhen.

Ein Vorteil dagegen: G-Sync kann auch Bilder verdoppeln, wenn die Ausgangsbildrate unter die minimale Bildwiederholfrequenz des Monitors fällt, und verhindert so ein Nachleuchten von Bildern, das so genannte Ghosting.

FreeSync – günstiger aber teils fehleranfällig

Das kann Freesync zum Beispiel nicht. Hier findet die Synchronisation mit der Grafikkarte nur innerhalb der Grenzen der variablen Bildwiederholungsrate des jeweiligen Monitors statt, was dann im Ergebnis schon mal zu Darstellungsfehlern wie dem oben genannten Ghosting führen kann. Allerdings sind Freesync-Bildschirme dafür auch merklich günstiger und beeinträchtigen nicht die Spieleperformance.

Anfangs war FreeSync nur AMD-Grafikkarten vorbehalten, so wie G-Sync nur von NVIDIA-GPUs unterstützt wird. Das hat sich 2019 mit der Einführung von "G-Sync Compatible" geändert. Mit diesem Feature ausgestattete FreeSync-Monitore erfordern für ihre adaptive Synchronisation keine proprietäre Hardware und sind damit nicht an ein bestimmtes Ökosystem gebunden.

Was ist denn nun besser?

Für welche Technologie man sich nun entscheidet, hängt wie so oft von den subjektiven Vorlieben ab, sowie von der Grafikkarte (besitzt man eine von AMD oder NVIDIA?) und vom eigenen Geldbeutel. Im Prinzip kann man aber sagen, dass G-Sync zwar etwas bessere Ergebnisse erzielt, doch auch FreeSync das Spielerlebnis deutlich aufwertet – vor allem, wenn man schnelle Rennspiele oder rasante Actiongames zocken will.

Bildschirmgröße

Zunächst einmal sollten Sie sich Gedanken darüber machen, wie groß der Monitor sein soll. Wie viel Platz haben Sie auf Ihrem Schreibtisch und wie weit sitzen Sie vom Bildschirm entfernt? Beachten Sie, dass 4K-Monitore in der Regel nicht weniger als 27 Zoll haben. Grund dafür ist, dass die 4K-Auflösung erst ab 27 Zoll wirklich zur Geltung kommt. 32 Zoll sind in der Hinsicht noch besser, aber kosten mehr und sind vielleicht schon zu groß für Sie. Wem ein Bildschirm wiederum nicht groß genug sein kann, der greift zu einem Modell mit 43 Zoll. Da hat man dann beinahe das Gefühl, einen Fernseher auf dem Schreibtisch stehen zu haben.

Bildwiederholrate und Farbdarstellung

Wichtige technische Aspekte sind die Bildwiederholfrequenz, Reaktionszeit und Farbdarstellung. Gerade für Gamer und Gamerinnen sind die ersten beiden Eigenschaften enorm wichtig. Sie sollten zu einem Gerät mit mindestens 144 Hertz greifen, sofern sie einen PC haben, der Spiele in 4K mit so einer hohen Bildrate stemmen kann. Die Reaktionszeit sollte auf jeden Fall unter 5 ms liegen. Achten Sie auf die Art des verbauten Panels. TN-Panels haben die niedrigsten Reaktionszeiten, liefern dafür aber nicht die Bildqualität, die VA- und IPS-Monitore bieten.

Adaptive Synchronisation und HDR

Haben Sie vor, viel auf Ihrem 4K-Monitor zu spielen, sollte außerdem die Unterstützung von AMD FreeSync oder NVIDIA G-Sync an Bord sein. Dann können Sie auf das suboptimale VSync verzichten und kommen in den Genuss flüssigerer Spielerfahrungen, sofern Ihre Grafikkarte das jeweilige Verfahren unterstützt. Ist Ihnen außerdem HDR wichtig, können Sie alle Geräte ausschließen, die das nicht bieten. Nicht jedes Spiel unterstützt diese Technologie, aber sie macht sich nicht nur beim Gaming bezahlt, sondern auch bei der Foto- und Videobearbeitung.

Äußere Faktoren: Je anpassbarer, desto besser

Zu guter Letzt spielen äußere Faktoren eine Rolle, zum Beispiel die Verstellmöglichkeiten. Lässt sich der Monitor schwenken oder neigen? Ist er höhenverstellbar? Je mehr Sie anpassen können, desto besser. Ein weiterer Pluspunkt sind USB-Ports. Sind diese vorhanden, ist der Monitor zugleich ein USB-Hub, an den Sie etwa Maus und Tastatur anschließen können. Vielleicht möchten Sie unbedingt einen Kopfhörerausgang am Bildschirm haben? Auch den bietet so manches Modell. Integrierte Lautsprecher sind ebenfalls nicht unüblich und praktisch, wenn Sie keine separaten Soundboxen haben, aber gelegentlich mit mehreren Leuten vor dem Rechner sitzen und alle etwas hören möchten. Kopfhörer sind dann keine Option. Des Weiteren spielt die Anschlussmöglichkeit an Ihre Grafikkarte eine wichtige Rolle. Viele Monitore haben sowohl einen HDMI- als auch einen DisplayPort-Eingang, manchen wiederum fehlt letzterer. Idealerweise werden beide Schnittstellen unterstützt.

Sie können einen 4K-Monitor nicht nur per HDMI oder DisplayPort an Ihren Computer anschließen, sondern mitunter auch per USB-C. Wenn sowohl der Bildschirm als auch Ihr Rechner einen passenden Anschluss bieten, besteht die Möglichkeit, dass Sie ein USB-C-Kabel als Videokabel nutzen können. Der USB-C-Anschluss muss dafür den DisplayPort-Alt-Modus unterstützen. Für den Fall, dass der Monitor keine USB-C-Buchse hat, können Sie ein Adapterkabel mit HDMI- oder DisplayPort-Stecker verwenden.

Der DisplayPort-Alt-Modus ist vor allem für Nutzer und Nutzerinnen von Laptops und MacBooks ohne DisplayPort- oder HDMI-Anschluss praktisch, die ihren portablen Computer an einen größeren Bildschirm anschließen möchten. Der Vorteil an dem Feature: Es unterstützt 4K bei 60 Hertz – und das ohne Komprimierung.

Sind 4K und UHD dasselbe?

Wer heute von 4K-Bildschirmen spricht, meint damit Modelle, die eine Auflösung von 3840 x 2160 Pixeln haben. Im Grunde ist 4K aber nur eine umgangssprachliche Bezeichnung. UHD (Ultra High Definition) ist eigentlich der korrekte Begriff. Die Bezeichnung 4K stammt ursprünglich aus dem Kinobereich und steht dort für die Auflösung von 4096 x 2160 Pixeln. Im Laufe der Jahre hat sie sich jedoch als Sammelbegriff für alle Auflösungen, die eine Breite von circa 4000 Pixeln haben, etabliert. Somit ist es nicht verwunderlich, dass viele Hersteller von 4K-Monitoren und -Fernsehern von "4K UHD" sprechen.

Wie reinige ich einen 4K-Monitor richtig?

Ein 4K-Monitor ist nicht günstig, deshalb sollte man ihn gut pflegen, damit man möglichst lange Freude daran hat. Bei der Reinigung gilt es ein paar Dinge zu beachten, damit Sie das Gerät nicht versehentlich beschädigen. Wollen Sie einfach nur Staub entfernen, wischen Sie mit einem Mikrofasertuch über den Bildschirm. Nehmen Sie keine anderen Tücher, denn sonst riskieren Sie, dass Kratzer entstehen. Haben Sie es mit Schmutz zu tun, der fest anhaftet, befeuchten Sie das Mikrofasertuch leicht. Achten Sie beim Reinigen darauf, dass die Elektronik nicht in Kontakt mit Wasser gerät. Zur Entfernung von besonders hartnäckigem Dreck können Sie ein Druckluftspray verwenden.

Was ist besser: HDMI oder DisplayPort?

Beide Schnittstellen sind grundsätzlich sehr gut geeignet, um ein schönes 4K-Bild aufs Display zu bekommen. Gamer und Gamerinnen sollten aber den DisplayPort vorziehen – zumindest dann, wenn der verwendete Gaming-Monitor kein HDMI 2.1 unterstützt. Mit der Version 2.0 sind bei 4K nur 60 Hertz möglich, während der DisplayPort 1.4 das Doppelte schafft. Und sollten Sie doch mal Spiele zugunsten höherer Performance in niedrigerer Auflösung laufen lassen, ist der DisplayPort ebenfalls im Vorteil: Die Version 1.4 unterstützt in der Full-HD-Auflösung, aber auch in 1440p, bis zu 240 Hertz. Das Problem hier bei HDMI: Viele Monitore sind so konfiguriert, dass sie über die Schnittstelle nicht mehr als 120 Hertz übertragen können.